INNOVATIVE, EINHEITLICHE PIPELINE FÜR DIE MASSENVERARBEITUNG VON 2D- UND 3D-DATEN

Ein Forschungsprojekt in Zusammenarbeit

mit der Ludwig-Maximilians-Universität München

Seit Einführung brauchbarer Hardware für VR- und AR-Technologien wie der Oculus Rift, HTC Vive oder Microsoft HoloLens explodiert der Markt für Visualisierungslösungen förmlich. Nach einer Schätzung von DigiCapital im VR Report entfielen auf den Enterprise AR-Markt im Jahr 2020 rund 4,5 Mrd. Dollar (ohne Hardwarekosten). Entsprechende Dienstleistungen werden in nahezu allen Branchen nachgefragt. Das Wachstum der Visualisierungsdienstleister ist letztlich durch die Mitarbeiterkapazität zur Erstellung präziser Modelle limitiert. Aus diesem Grund werden deutlich bessere Automatisierungslösung mit stark beschleunigtem Erstellungsprozessen Unternehmen in die Lage versetzen, mehr und v.a. größere Projekte effizient abzuwickeln.

Wir haben uns daher die Frage gestellt, wie kann man heute Lösungen entwickeln, die von aktuellsten Technologien profitieren. Durch den Fördergeber Bayerisches Staatsministerium für Wirtschaft, Energie und Technolgie wurde für uns Grundlagenforschung zusammen mit der LMU als wissenschaftlichen Partner möglich. Das Forschungsprojekt startete 2018. Als Ziel wurde damals die Beantwortung der Frage formuliert:

„Ist es möglich ein modulares selbsoptimierendes Reduzierungssoftwaretool zur automatischen beschleunigten Generierung von VR-tauglichen 3D-Modellen aus CAD-Dateien zu entwicklen?“

Dies war die Geburtstunde unseres Assistenten, der zu einem neuen Ökosystem herangewachsen ist, welches von Anbeginn auf modernsten Technologien aufbaut:

- Cloud-Technologie

- Web-Technologie

- Künstliche Intelligenz

Vorteile gegenüber anderen Produkten

- Weltweit erste KI-Lösung zur Polygonreduktion

- Immense Geschwindigkeitein im Vergleich zu anderen Anbietern (bis zu Faktor 400x schneller gemessen)

- Setzt keinerlei Expertise voraus

- Kleinstmöglicher Implemantationsaufwand

- Höchste Saklierbarkeit und Flexibilität

Selbstlernende Künstliche Intelligenz

Unsere KI lernt im iterativen Prozess, welches Ergebnis erwünscht wird. Dafür reicht es vollkommen aus, Ergebnisse zu bewerten. Dieser Prozess setzt keine Expertise voraus und führt binnen weniger Minuten zum Wunschergebnis. Die KI-gestüstzte Reduktion ist im Vergleich zu klassischen Lösungen um einige viele Magnituden schneller.

Cloud-Pipeline

- cloudbasiert und managed (es wird keine eigene Infrastruktur benötigt)

- überall und jederzeit verfügbar (ca. 99,6%)

- liefert universell lesbare Formate für Weiterverarbeitung jeder Art

- Lässt sich mit minimalem Aufwand in jede vorhandene Struktur integrieren

Einfache Implementierung

Unsere Lösung kann als Client-Applikation, direkt im Web-Browser oder via API angesprochen werden. So können Unternehmen jeder Größe direkt loslegen oder unsere Lösung ohne großen Aufwand in Ihre Struktur implemantieren.

Kosten wiederkehrender Aufgaben

3D-Künstler und Techical Artists machen ungerne repititive Aufgaben. Zudem sind Sie als Ressource, aufgrund der Kosten keine dafür geeignete Ressource. Diese Prozesse übernimmt unsere Lösung zu einem Bruchteil der Kosten.

Milestones:

- 2018 – Start unseres gemeinsamen Forschungsprojekts mit der LMU München (Herr Prof. Dr. Butz)

- Mai 2021 – Start der Betatests mit ausgewählten Partnern der Industrie

- voraussichtlich Juni 2021 – WAY Digital Solutions erwartet erste Ergebnisse der Betatests

Produkt-Vision & Future Plans

Selbst in Hochzeiten steigender Bandbreiten und technologischer Entwicklung besteht ständiger Optimierungsbedarf. Als Entwickler in den Bereichen 2D & 3D, Desktop & Mobile AR/VR/XR ist es uns immer ein Anliegen, die Verarbeitung von Daten mit allen technisch möglichen Mitteln voranzutreiben.

In Zeiten von Cloud, SaaS, steigender Erreichbarkeit und Skalierbarkeit müssen Pipelines neu gedacht werden. Unser Ansatz bedient sich daher nicht nur altbekannter Automatismen, Algorithmen und Technologien, sondern auch Künstlicher Intelligenz. Was 2018 als Forschungsprojekt in Zusammenarbeit mit der LMU München begann, nimmt fortwährend Form an und macht es uns demnächst möglich, unseren Ansatz mit ausgewählten Industriepartnern zu evaluieren.

Vorteile gegenüber klassischem Vorgehen

- Kostenersparnis durch Automatisierung und Massenverarbeitung

- Polygonreduktion auch durch Laien möglich

- High-Poly, Low-Poly, und alles dazwischen

- Erreicht optimale Ergebnisse in kürzester Zeit

- Optimale Performance für Echtzeitanwendungen

- Zeitersparnis für Render-Pipelines

Was ist Polygonreduktion und welches Problem löst man damit?

Das Problem

Polygone sind relativ teuer – Die verfügbare Rechenzeit bei Echtzeitanwendungen ist sehr kurz, höchstens jedoch 1 Sek / 30 (30 FPS). Schlecht oder nicht optimierte 3D-Modelle sind oftmals einer der Hauptgründe dafür, dass dieses Rechenzeit-Limit überschritten wird. Moderne Hochleistungs-Hardware kann vergleichsweise hohe Mengen an Polygonen darstellen, nicht jedoch übliche Consumer- und Mobile-Geräte. Daher ist es, basierend auf der Leistung der Zielplattform, unter Umständen unabdinglich, Polygone auf die richtige Weise zu reduzieren. Die Reduktion der Polygone bedeutet in der Regel allerdings den Verlust von Oberflächendetail – wie also stellt man möglichst viel Detail mit möglichst wenig Rechenzeit dar?

Polygonreduktion und Normal Mapping – Ein untrennbares Team!

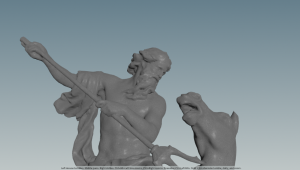

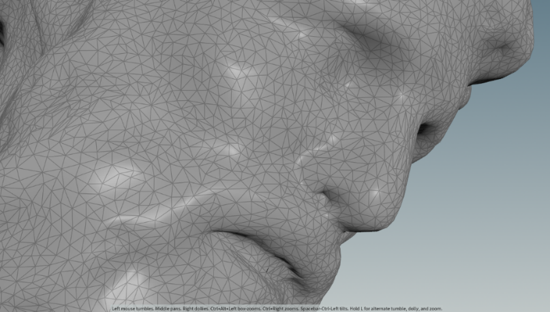

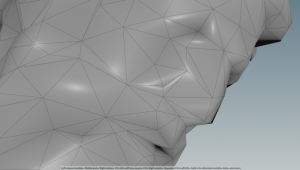

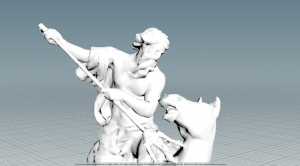

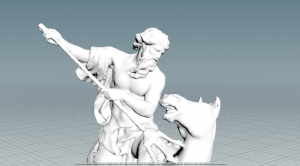

Hochdetaillierte oder gescannte 3D-Modelle haben naturgemäß eine hohe Polygondichte. Jede mögliche Reduktion verursacht also ein DELTA verglichen mit dem Grundmodell. Im folgenden Beispiel wird die Polygondichte auf 3% des Grundmodells reduziert. Die notwendige Rechenzeit beträgt also Rechenzeit Grundmodell * 0.03

Was bedeuted Normal Mapping?

Geometrie lässt sich anhand zweier Merkmale eindeutig identifizieren:

- Silhouette

- Lichtreflexionswinkel

Normal-Mapping speichert den Lichtreflexionswinkel PIXEL-basiert. Anstelle also ausschließlich die verfügbaren Polygone und dessen Normal-Vektoren zu verarbeiten, ergänzt man die ursprünglich resultierende Lichtreflektions-Information als TEXTUR auf ein reduziertes Modell.

Die notwendige Rechenzeit ist verglichen zum Effekt marginal. Die Oberflächendetails erscheinen wiederhergestellt – nicht so die Silhouette. In der objektiven Wahrnehmung fällt das Oberflächendetail allerdings stärker ins Gewicht als die Granularität der Silhouette.

Benchmark

Wir vergleichen Instanzen des gescannten Modells (4×4 Grid) mit Instanzen des reduzierten Modells (32×32 Grid). Wir rendern also 64x so viele Objekte mit 2-facher Geschwindigkeit trotz Verwendung von 2x 2K Texturen (Normal & AO).

Interesse am Thema Polygonreduktion?

Sie interessieren sich für unser Forschungsprojekt zur Polygonreduktion? Dann kommen Sie mit uns in Kontakt. Wir freuen uns über jedes Feedback und fachlichen Austausch. Für Rückfragen seht Ihnen Gerd.Otto@waygroup.de zur Verfügung.